团队研究经过校准的AI和深度学习模型以更可靠地诊断和治疗疾病

随着人工智能(AI)越来越多地用于诸如诊断和治疗疾病等关键应用中,从业人员和患者可以信赖的医疗保健预测和结果将需要更可靠的深度学习模型。在最近的 预印本中 (可通过康奈尔大学的开放获取网站arXiv获得),由劳伦斯·利弗莫尔国家实验室 (LLNL)的计算机科学家领导的团队 提出了一种新颖的深度学习方法,旨在提高分类器模型的可靠性,该模型旨在从诊断中预测疾病类型图像,其附加目标是在不牺牲准确性的前提下使医学专家能够解释。该方法使用一种称为置信度校准的概念,该概念可以系统地调整模型的预测,以符合人类专家在现实世界中的期望。

主要作者和LLNL计算科学家Jay Thiagarajan解释说:“可靠性是重要的准绳,因为AI在高风险应用中变得越来越普遍,当出现问题时会产生真正的不良后果。” “您需要系统地说明该模型在实际环境中的可靠性,然后将其应用到其中。如果像改变总体多样性这样简单的事情会破坏您的系统,则需要知道这一点,而不是部署它,并且然后找出来。”

在实践中,量化机器学习模型的可靠性具有挑战性,因此研究人员引入了“可靠性图”,其中包括推理循环中的专家以揭示模型自治性与准确性之间的权衡。Thiagarajan解释说,通过允许模型在置信度较低时推迟进行预测,可以对模型的可靠性进行整体评估。

在论文中,研究人员考虑了用于皮肤癌筛查的病变的皮肤镜检查图像-每个图像均与特定的疾病状态相关:黑色素瘤,黑素细胞痣,基底细胞癌,光化性角化病,良性角化病,皮肤纤维瘤和血管病变。使用常规指标和可靠性图,研究人员表明,与现有的深度学习解决方案相比,校准驱动的学习产生了更加准确和可靠的检测器。在这个具有挑战性的基准测试中,他们的准确率达到了80%,而标准神经网络的准确率则为74%。

然而,比提高准确性更重要的是,预测校准为在科学问题中构建可解释性工具提供了一种全新的方式,Thiagarajan说。该团队开发了一种自省方法,其中用户输入有关患者的假设(例如某种疾病的发作),并且模型返回与该假设最大程度吻合的反事实证据。使用这种“假设分析”,他们能够识别不同类别的数据之间的复杂关系,并阐明了该模型的优缺点。

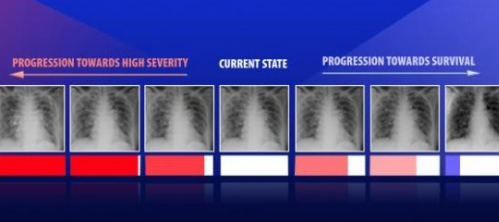

蒂亚加拉詹说:“我们正在探索如何制作一种可能支持更复杂的推理或推理的工具。” 这些AI模型通过将您的假设置于预测空间中,系统地提供了获得新见解的方法。问题是,“如果已被诊断出患有疾病A和疾病B,图像应如何显示?” 我们的方法可以为该假设提供最合理或最有意义的证据。我们甚至可以获得患者从状态A到状态B的连续转换,由专家或医生定义这些状态是什么。”

最近,Thiagarajan将这些方法用于研究诊断为的患者的胸部X射线图像,这些患者是由新型SARS-CoV-2引起的。为了了解人口统计学,吸烟习惯和医疗干预等因素对健康的影响,Thiagarajan解释说,AI模型必须分析的数据量远远超过人类可以处理的数据,并且医学专业人员必须对结果进行解释才能有用。他说,可解释性和自省技术不仅将使模型更强大,而且还可以提供一种全新的方式来创建用于医疗保健应用的模型,从而使医生能够形成有关疾病的新假设,并帮助决策者制定影响公共卫生的决策。 ,例如持续中的大流行。

“人们希望将这些AI模型整合到科学发现中,” Thiagarajan说。“当出现像COVID这样的新感染时,医生正在寻找证据以更多地了解这种新型病毒。系统的科学研究总是有用的,但是我们产生的这些数据驱动的方法可以极大地补充专家们可以用来了解这些疾病的分析。机器学习不仅可以进行预测,还可以应用,并且该工具以非常聪明的方式实现了这一目标。”

贾加拉让开始的这项工作部分是为了寻找不确定性量化(UQ)的新技术,这项工作是由 能源部的高级科学计算研究 计划资助的。他与LLNL的团队成员一起,已开始在许多科学应用中利用UQ集成的AI模型,并最近与加利福尼亚大学旧金山医学院就临床问题中的下一代AI展开了合作。

标签: 深度学习模型