保护机器学习模型的隐私

当您看到有关用于检测健康问题的人工智能(AI)的头条新闻时,通常这要归功于医院向研究人员提供数据。但是这样的系统并不像它们可能的那样健壮,因为这样的数据通常仅来自一个组织。

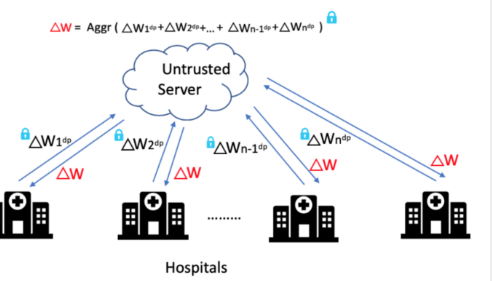

可以理解的是,医院对共享数据的谨慎态度可能会使数据泄露给竞争对手。解决该问题的现有努力包括“联合学习”(FL)技术,该技术使分布式客户端可以协作学习共享的机器学习模型,同时保持其培训数据本地化。

但是,即使最前沿的FL方法也存在隐私问题,因为使用经过训练的模型的参数或权重可能泄漏有关数据集的信息。在这种情况下,要确保隐私,通常需要熟练的程序员花大量时间来调整参数-这对于大多数组织而言并不实际。

麻省理工学院CSAIL的一个小组认为,医疗机构和其他组织将从他们的新系统PrivacyFL中受益,该系统可以用作安全,保护隐私的FL的真实世界模拟器。它的主要功能包括等待时间模拟,对客户端离开的鲁棒性,对集中式和分散式学习的支持以及基于差分隐私和安全的多方计算的可配置隐私和安全机制。

麻省理工学院首席研究科学家拉拉娜·卡加尔(Lalana Kagal)说,出于多种原因,模拟器对于联合学习环境至关重要。

评估准确性。 SKagal说,这样的系统“应该能够模拟联邦模型并将其准确性与本地模型进行比较。”

评估花费的总时间。远程客户端之间的通信可能会变得昂贵。模拟对于评估客户端-客户端和客户端-服务器通信是否有益很有用。

评估收敛的近似界限以及收敛所需的时间。

模拟实时辍学。使用PrivacyFL的客户可能会随时退出。

我们正在使用从该模拟器中学到的经验教训,开发一个可以在现实世界中使用的端对端联合学习系统,例如,合作医院可以使用这种系统进行培训具有隐私保护功能的强大模型可以预测复杂的疾病。

标签: