新的深度学习技术导致材料成像突破

超级计算机帮助研究人员研究复杂现象的原因和影响——通常是按照这个顺序。然而,科学家有时需要根据可观察的结果来推断科学现象的起源。众所周知,这些所谓的逆问题很难解决,尤其是当必须分析的数据量超过了传统的机器学习工具时。

为了更好地理解逆问题,来自美国能源部 (DOE) 橡树岭国家实验室 (ORNL)、NVIDIA 和 Uber Technologies 的团队在一个广泛使用的名为 Horovod 的通信库中开发并展示了两种新技术。

该平台由 Uber 开发,训练深度神经网络(DNN),使用算法模仿和利用人脑的决策能力进行科学应用。由于 Horovod 依靠单个协调器向许多不同的工作人员(即本例中的 GPU)提供指令以完成此过程,因此大规模深度学习应用程序在训练期间经常会遇到明显的减速。

研究人员的方法从传统的协调员 - 工作人员流程中删除了重复步骤,以提高速度并超越现有方法,从而使他们能够发现材料成像领域中古老逆问题的第一个近似解决方案。他们的研究结果发表在第 19 届 USENIX 网络系统设计与实施研讨会论文集上。

“据我们所知,这是卷积神经网络分布式训练中每秒最多的浮点运算,”ORNL Scale 组分析和 AI 方法的计算科学家 Junqi Yin 说。“我们计划使用生成的代码 STEMDL 来对未来几代超级计算机进行基准测试。”

一起更强大

为了减少协调员与工作人员之间的通信,这通常涉及多次重复相同的请求,该团队引入了一个响应缓存,该缓存存储来自 Horovod 中每个请求的元数据。科学家们的第一个新策略是这种缓存方法,它允许 Horovod 立即识别并自动计算熟悉的请求,而不会延迟 DNN 训练。

他们的第二项新技术涉及对多个 DNN 模型的数学运算进行分组,通过利用每个模型计算中的相似性,简化任务并提高缩放效率(每个训练步骤处理的图像总数) 。这个过程也导致了电力使用的显着改善。

通过战略性地对这些模型进行分组,该团队的目标是最终在多个 GPU 上训练一个模型,并达到与每个 GPU 训练一个模型相同的效率。

NVIDIA 的开发技术工程师 Josh Romero 将新策略整合到 Horovod 中,使用户能够在任何规模的高性能计算机上更有效地训练 DNN。

罗梅罗说:“所有工人必须就操作顺序以及在任何给定时间分发的信息达成一致。” “我们找到了改善这一物流流程的方法。”

这两种方法单独提高了 Horovod 的性能,但将它们结合起来几乎使扩展效率翻了一番,该团队通过在 IBM AC922 Summit 系统的所有 27,600 个 GPU 上运行 STEMDL 代码来衡量这一点。美国最快的超级计算机 Summit 位于 ORNL 的橡树岭领导计算设施,这是美国能源部科学办公室用户设施。

“这些能力使我们能够训练分布在整个峰会上的单个神经网络,其扩展效率和计算性能比以前在大规模上可能实现的要高得多,”ORNL 前计算科学家兼首席研究员 Nouamane Laanait 说。该团队的峰会分配,这是通过创新和新颖的计算对理论和实验的影响计划授予的。

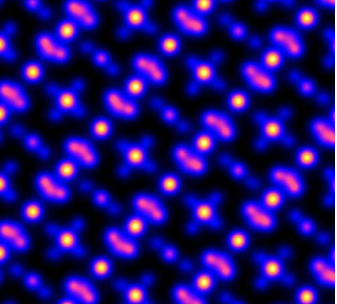

STEMDL 等卷积神经网络是图像分析的理想 DNN。该团队专门设计了这个应用程序来解决长期存在的材料成像逆问题,该问题需要对扫描透射电子显微镜数据进行精确分析。

“使用神经网络模型的一个优点是,你可以将许多难以在数学方法中编码的因素结合起来,以解决逆问题,”Laanait 说。“通过在数据集上训练这些模型,你可以教它们忽略噪音和其他缺陷。”

包罗万象的架构

Summit 的独特组件使这项研究成为可能。例如,在超级计算机的 GPU 之间分配 DNN 训练揭示了传统 Horovod 计算中存在的性能瓶颈。这些障碍在整个训练过程中累积起来,然后才变得明显,因为它们开始阻碍计算时间,这使得它们很难或不可能在较小的系统上看到。

“在一小时内,您就知道解决方案的精确度,这使您可以比在较小的系统上更快地调整原型,这可能需要数天或数周才能确定模型的精确程度或将问题映射到模型的程度, ”拉奈特说。

此外,Summit 具有高带宽通信路径,可以将数据从一个地方移动到另一个地方,其本地存储系统(称为突发缓冲区)具有足够的内存,允许研究人员在每个节点上模拟和存储超过 1 TB 的数据。最后,NVIDIA 张量核心(适用于深度学习应用程序的专用处理单元)加快了团队的代码速度,并帮助他们达到了比传统处理器更高的性能水平。

该团队的研究结果可以应用于现有的深度学习应用程序和以前未解决的逆问题,以回答基础科学问题。展望未来,研究人员希望使用更少的计算能力重新创建他们的结果,并根据实验设施生成的不断增加的数据量训练更大的模型。

“将更大的数据集和模型与更多的计算能力相结合通常会提高 DNN 的有效性,”Laanait 说。“我们不知道这些改进的上限是多少,所以找出答案的唯一方法是继续试验。”

标签: