使用深度神经网络实现卓越的相位恢复和全息图重建

深度学习已经为各种成像任务取得了基准结果,包括全息显微镜,其中一个重要步骤是使用仅强度测量来恢复样本的相位信息。通过在精心设计的数据集上进行训练,深度神经网络已被证明在准确性和计算效率方面优于经典的相位检索和全息重建算法。然而,模型泛化是指将神经网络的能力扩展到训练期间从未见过的新型样本,这对于现有的深度学习模型仍然是一个挑战。

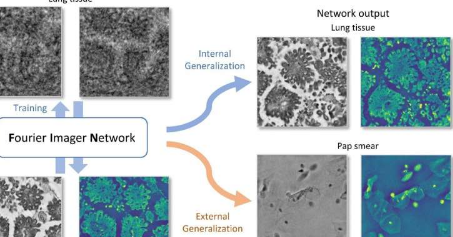

加州大学洛杉矶分校的研究人员最近创建了一种称为傅立叶成像网络(FIN)的新型神经网络架构,它展示了对看不见的样本类型的前所未有的泛化能力,还在相位检索和全息图像重建任务中实现了卓越的计算速度。在这种新方法中,他们引入了空间傅里叶变换模块,使神经网络能够利用整个图像的空间频率。加州大学洛杉矶分校的研究人员在人类肺组织样本上训练了他们的FIN模型,并通过重建人类前列腺和唾液腺组织切片的全息图以及在训练阶段从未见过的巴氏涂片样本证明了其优越的泛化能力。

发表在Light:Science&Applications中,据报道,与经典全息图重建算法和最先进的深度学习模型相比,这种基于深度学习的新框架实现了更高的图像重建精度,同时将重建时间缩短了~50次。这种新的深度学习框架可广泛用于为各种显微成像和计算机视觉任务创建高度泛化的神经网络。

这项研究由AydoganOzcan博士领导,他是加州大学洛杉矶分校校长教授和Volgenau工程创新主席,也是霍华德休斯医学研究所的HHMI教授。这项工作的其他作者包括来自加州大学洛杉矶分校电气与计算机工程系的HanlongChen、LuzheHuang和TairanLiu。Ozcan教授还在加州大学洛杉矶分校的生物工程和外科部门担任教职,并且是加州纳米系统研究所的副主任。

标签: